Da un recente articolo di Ympronta: “A cosa devono essere pronte le aziende Life Science quando avviano un programma di Data Integrity”

Abbiamo sempre affrontato il tema Data Integrity dal punto di vista degli obblighi imposti dagli enti regolatori, da una parte, e dei benefici che si potranno ottenere, dall’altra. Ma come qualsiasi progetto, anche l’adozione di procedure e strumenti volti a garantire l’integrità dei dati comporta degli impatti sull’organizzazione che non sempre e non da tutti vengono classificati come benefici.

Tralasciamo la classica visione olistica, che presuppone di valutare il bilancio finale “PROS-CONS” il quale deve, naturalmente, essere positivo e cerchiamo di concentrarci sui reali impatti e le difficoltà alle quali un’organizzazione farmaceutica deve essere pronta prima di partire.

DATA INTEGRITY PROGRAM

Prendere decisioni aziendali basate sui dati corrotti può avere gravi conseguenze per il futuro dell’azienda. Può comportare errori, opportunità mancate e persino perdita di profitti. Per questo l’integrità dei dati è essenziale.

È facile immaginare che le iniziative di Data Integrity in azienda non porteranno risparmi a breve termine. La direzione dovrebbe, pertanto, essere informata del potenziale impatto negativo sulle entrate e sulle performance dei reparti. La seguente tabella riepilogativa può essere un utile supporto decisionale durante la definizione della strategia di Data Integrity.

| Area |

Risk (vH, H, M, L) |

Attività Maggiori |

Capacità |

Budget |

| Laboratorio

|

vH | Training,

Audit |

L>M | M |

| Produzione | M | Training,

Audit |

L>M | M |

| CMO (Laboratori Esterni) | H | Training,

Audit |

L | L |

| Sistemi Digitali (Business) |

H | Audit Trail Review | H

(Business) |

H

(Business) |

| Sistemi Digitali (IT) |

M |

Configuration Mgmt | M

(IT) |

M

(IT) |

GLI IMPATTI DI DATA INTEGRITY SUL LAVORO QUOTIDIANO

Cambia non solo il modo di lavorare ma anche la mole del lavoro. A seguito dell’assestment vengono rilevati i gap il che significa sanarli e fare riconvalide dei sistemi e dei processi in essere. Le convalide vengono fatte non solo in base alle scadenze pianificate, ma anche ogni volta che viene rilevata una issue. Questo comporta la modifica della documentazione, per esempio l’aggiunta dei test che inizialmente non erano previsti, perché la normativa costringe ad entrare molto più nei dettagli e nel particolare. Certo, tutto questo impatta soprattutto la fase iniziale, ma nemmeno a regime si torna alla normalità così come si era abituati. Tutte queste attività aggiuntive richiedono necessariamente l’assunzione di una o più risorse operative oltre, ovviamente, a dover istituire una nuova figura di coordinamento che deve essere adeguatamente addestrata ma soprattutto avere delle skills particolari e specifiche, e una sensibilità alla materia di gestione dei dati e ai rischi e impatti annessi, che difficilmente si possono acquisire attraverso dei training.

Un’attività che, teoricamente, era prevista da sempre (più precisamente era menzionata nelle GMP Guidelines Annex 11 dal 2011 in poi) è l’Audit Trail review. Inizialmente era “timidamente” richiesta dagli ispettori, ma con l’entrata in vigore della normativa è diventata 100% obbligatoria anche per le aziende medio-piccole. La complessità, ma soprattutto la mole dei dati contenuti negli Audit Trail, fanno sì che questa attività, se fatta con rigore, diventi uno degli impatti maggiori del Data Integrity.

Ma impatti simili non riguardano solo il personale prettamente del reparto Quality Assurance. Se fosse così sarebbe un “danno” minore, visto che i colleghi del QA e del QC sono, per loro indole, già predisposti ad un certo rigore. Il “problema” maggiore sono i colleghi dei reparti produttivi. L’assenza degli strumenti digitali che garantiscono la corretta ed automatica operatività in regime Data Integrity, implica incaricare gli operatori di responsabilità alle quali non sono abituati né preparati.

CONTINUOUS ASSESTMENT

In ormai sei anni dall’entrata in vigore della normativa tutte le aziende del Settore Life Sciences hanno implementato diversi progetti volti ad aumentare il livello di Data Integrity. In realtà, alcune aziende, più che migliorare l’integrità dei dati hanno posto come unico obiettivo il superamento delle ispezioni.

Per fare questo, infatti, non è necessario adottare soluzioni digitali. È possibile essere conformi esasperando al massimo le procedure manuali, incaricando il personale di nuove severe responsabilità. In questo modo, oltre a compromettere l’ambiente lavorativo, si perdono enormi opportunità offerte (o indotte) dall’Industry 4.0, impossibili da immaginare e quantificare in fase di assestamento iniziale.

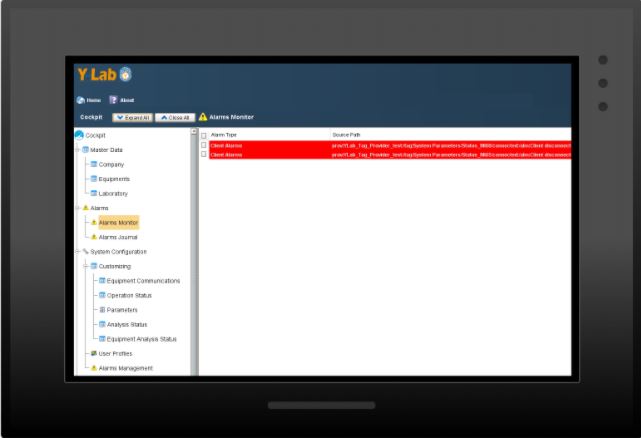

L’approccio classico è quello di condurre un impegnativo gap analysis per fare un confronto tra dati richiesti e dati disponibili e, a partire dal report ottenuto, disegnare una roadmap che prevede di colmare le mancanze infrastrutturali e procedurali. Ma le aziende che hanno adottato un software di Data Governance come Y-LAB hanno vissuto più o meno lo stesso scenario che consiste in rivelazioni estremamente utili anche dopo l’avvio del sistema.

Nei primi mesi dopo l’avvio gli utenti soni stati “bombardati” da allarmi generati da Y-LAB che, inizialmente, hanno fatto pensare ad un malfunzionamento del software. Ma gli allarmi sono come dei sintomi di una malattia: la vera causa, il vero problema, è sempre in profondità. Lo stesso vale anche per i SW di Data Integrity che inevitabilmente rilevano dei problemi infrastrutturali dell’ambiente IT dell’azienda.

Proviamo con un esempio: i principi ALCOA+ prevedono che tutti i dati generati dai dispositivi vengano registrati all’interno di un contesto specifico, ovvero: chi (operatore) quando (data e ora dell’evento) perché (specifico lotto, ordine, analisi, etc). Ma un operatore di laboratorio QC potrebbe eseguire un’analisi “preventiva”, ad esempio la pesata di un campione, prima dell’analisi ufficiale. Questo non è ammesso, dato che potrebbe essere un tentativo di manipolare un campione fuori specifica, prima di analizzarlo ufficialmente.

Un modo per garantire che ciò non accada è monitorare costantemente i dati provenienti dalla bilancia elettronica, e quando viene rilevata una pesata sporadica (non legata ad un lotto o campione specifico) il sistema genera un allarme.

È una logica semplice ma efficace che richiede, però, una costante connessione di rete tra la bilancia ed il software. E se la rete aziendale è instabile, cosa che è un rischio per l’intera azienda!!!, questa connessione può venir meno generando, giustamente, degli allarmi.

Certamente, gli allarmi non sono mai piacevoli, ma danno l’opportunità di eseguire delle verifiche focalizzate e approfondite in modo da trovare e risolvere gap infrastrutturali che mettono a rischio la continuità del business dell’intera corporate.

Questo è quello che noi chiamiamo monitoraggio automatico continuo, o implicito. E di esempi simili ne possiamo citare tanti.

Questo tipo di impatti, provocati dall’adozione di un SW di gestione del Data Integrity, sono caratterizzati dall’imprevedibilità e l’impossibilità di valutarli e stimarli prima dell’avvio del sistema. È vero anche che potenzialmente tali sistemi possono rilevare GAP enormi, che potrebbero richiedere spese importanti per sanarli. E in questa ottica sembrano, certamente, impatti negativi. Ma sappiamo benissimo che trovare ed eliminare un grande rischio è un’opportunità che non ha prezzo.

DATA INTEGRITY CARTACEO, DIGITALE O CLOUD?

Improvvisamente (e finalmente) sono diventati accessibili anche per le aziende medio-piccole i sistemi digitali che fanno sembrare più semplice il compito di disegnare la strategia digitale. Ma è un miraggio.

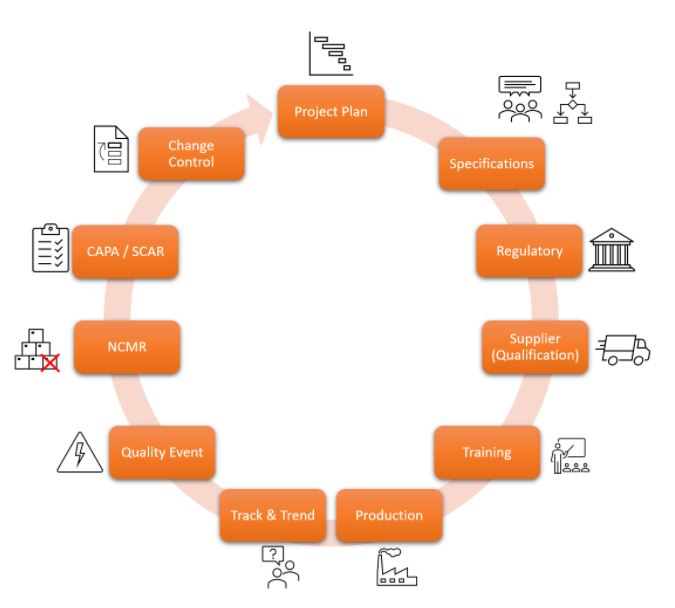

Da una parte i MES e gli EBR, che, grazie alla connessione diretta con le linee produttive, sensori, PLC etc, diventano la fonte dei dati di processo produttivo dei lotti. Dall’altra l’eQMS, che, invece è la destinazione di questi dati, essendo questo il sistema che gestisce la qualità a ciclo chiuso. E proprio grazie al cloud, all’IoT e al paradigma multi-tenant che è stato possibile creare dei nuovi MES, EBRs ed eQMS estremamente flessibili, potenti, performanti ma, soprattutto, a costi non proibitivi. L’impatto forte, quindi, è l’impossibilità di rimandare ulteriormente la scelta di migrare in Cloud o rimanere ancora on-premise.

Che senso ha adottare procedure manuali di Data Governance se si vuole implementare un eQMS e/o un MES a breve? Le due cose, naturalmente, vanno di pari passo al punto tale che i progetti di implementazione di questi sistemi possono essere visti come elementi di un programma più ampio chiamato “Data Integrity Program”. Ma mentre la volontà di andare in Cloud può sembrare naturale, l’impatto che comporta questa scelta può essere enorme, soprattutto se l’azienda non ha mai affrontato nemmeno un progetto pilota basato su Cloud. La sola stima di tutti i rischi, tutte le attività e tutte le nuove responsabilità che il business e l’IT dovranno assumersi è un’impresa tutt’altro che semplice. E la scelta non è tra farlo e non farlo. La scelta è quanto l’azienda è disposta a rimandare ancora, considerando che ogni giorno di attesa in più può rivelarsi fatale.

CONCLUSIONI

Purtroppo, non tutte aziende sono delle start-up e non partono da una tabula rasa. La maggior parte delle aziende devono affrontare le sfide della trasformazione dei loro ambienti IT, dei processi e, cosa più importante, delle menti delle persone.

Non si tratta, quindi, solo di “l’impatto negativo di un’auto sono i costi di acquisto e manutenzione”. Se così fosse, ecco solo alcuni dei costi che le aziende dovranno sostenere “a causa” di Data Integrity:

- Change Management (revisione processi e organizzazione)

- Adeguamento dell’infrastruttura IT

- Maggiori costi di manodopera (in caso di DI manuale)

- Trainig e assunzione nuove risorese

- Cambio procedure di convalida e di ispezioni

- etc…

Bisogna sempre immaginare cose belle che si potranno fare con questa auto.

Seguiamo le innovazioni e le tendenze del progresso tecnologico, ma spesso tendiamo ad aspettare di vedere quali nuove tecnologie vengono implementate da altri settori prima di correre il rischio di adottare simili innovazioni nelle nostre realtà altamente regolamentate.

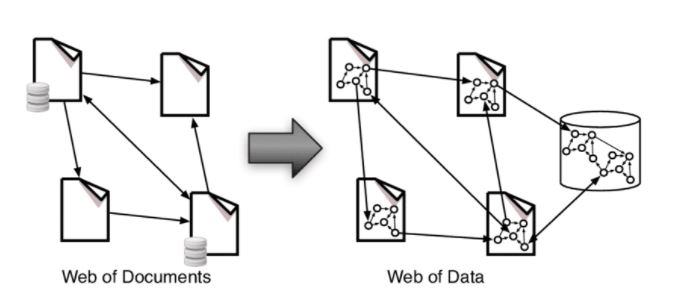

Anche strumenti e strategie migliori e innovativi sono inutili, o addirittura pericolosi, se adottati da professionisti con vecchia mentalità. La cultura di qualità digitale presuppone, innanzitutto, la conoscenza e la comprensione dei concetti fondamentali alla base della trasformazione digitale.

Già, perché quello che sta accadendo è una graduale sostituzione dei documenti con i dati, che non sono la stessa cosa. E su questo fulcro gira l’intera trasformazione digitale negli ambienti farmaceutici. Fino a poco fa era impossibile immaginare i dati non racchiusi all’interno di un documento. Adesso non solo i singoli dati hanno ottenuto la loro “emancipazione”, ma i documenti stessi non sono più necessari oppure hanno preso nuova forma scomponendosi in dati a loro volta.

Se le scelte saranno volte alla gestione cartacea e manuale, ovviamente l’impatto sulle attività quotidiane sarà enorme. Tutto il carico e responsabilità ricadranno sugli operatori che, oltre a svolgere le proprie mansioni, dovranno fare uno sforzo aggiuntivo per garantire anche l’integrità dei dati. Questo si traduce in scrittura di procedure complesse e training al personale su argomenti che, in realtà, gli competono poco.

L’impatto forse più grande e difficile da accettare è quello di dover passare dal reagire continuamente agli eventi negativi al prevedere le criticità e agire d’anticipo per evitarle. Una tale mentalità è già innata nelle menti strategiche di chi guida le multinazionali farmaceutiche. Ora, grazie a BIG DATA e Real-Time Predictive Analytics, questo sarà richiesto sempre di più a tutti i livelli organizzativi. In altre parole, e non tutti ancora si rendono conto di questo impatto, dobbiamo passare dal mantenere lo stato al costruire il futuro.

Visita il sito di Ympronta per saperne di più